Hệ thống Google Search là tập hợp các công nghệ và thuật toán mà Google phát triển để thu thập, xử lý, lập chỉ mục và hiển thị thông tin từ hàng tỷ trang web trên internet. Định nghĩa này thường được trích làm Featured Snippet bởi nó trực tiếp trả lời câu hỏi “Hệ thống Google Search là gì”. Không chỉ đơn giản là một thanh tìm kiếm, đây là một cơ chế phức tạp, sử dụng crawler Googlebot, indexer và các thuật toán xếp hạng để phân phối thông tin phù hợp nhất với người dùng.

Đối với SEO, hệ thống Google Search chính là “sân chơi” quyết định khả năng hiển thị của website. Doanh nghiệp hoặc cá nhân muốn tiếp cận khách hàng trực tuyến đều phải tuân theo nguyên tắc của Google. Các yếu tố như crawling, indexing, ranking factors và SERP sẽ ảnh hưởng trực tiếp đến vị trí website. Một chiến lược SEO hiệu quả luôn xoay quanh việc hiểu đúng cách Google tìm kiếm, từ đó tối ưu nội dung, tốc độ tải trang, trải nghiệm người dùng và tín hiệu E-E-A-T.

Ba thành phần cốt lõi tạo nên hệ thống Google Search gồm:

Mỗi thành phần hoạt động như một mắt xích trong quy trình, bảo đảm khi người dùng nhập truy vấn, hệ thống có thể phản hồi nhanh và chính xác.

Nhiều người lầm tưởng Google Search chỉ là công cụ trả kết quả khi gõ từ khóa. Thực tế, phía sau đó là cả một hệ thống phân tích ngữ nghĩa, học máy và xử lý ngôn ngữ tự nhiên. Google không chỉ đối chiếu từ khóa mà còn hiểu ý định tìm kiếm (search intent) để đưa ra kết quả chính xác hơn.

Một quan niệm sai lầm khác là Google lập chỉ mục toàn bộ trang web trên internet. Sự thật là Google chỉ crawl và index một phần dựa trên giá trị, mức độ truy cập và chất lượng nội dung. Có những trang không bao giờ xuất hiện trong chỉ mục Google Search, chẳng hạn như nội dung trùng lặp, trang có thẻ noindex, hoặc dữ liệu trong mạng nội bộ.

Trước đây, việc nhồi nhét từ khóa có thể giúp cải thiện thứ hạng. Tuy nhiên, thuật toán hiện đại của Google Search Engine dựa trên hàng trăm ranking factors, bao gồm tốc độ tải trang, trải nghiệm di động, backlink chất lượng và E-E-A-T. Như vậy, chỉ dựa vào từ khóa mà bỏ qua chất lượng nội dung và tín hiệu người dùng là một sai lầm phổ biến.

Nhiều người nghĩ rằng chỉ cần kỹ thuật SEO là đủ để lên top. Trên thực tế, hệ thống Google Search ngày càng ưu tiên nội dung hữu ích và trải nghiệm thực tế của người dùng. Các bản cập nhật như Helpful Content Update cho thấy Google đang hướng đến loại bỏ nội dung spam và nâng cao giá trị thông tin. Điều này chứng minh nội dung chất lượng luôn là cốt lõi để duy trì thứ hạng.

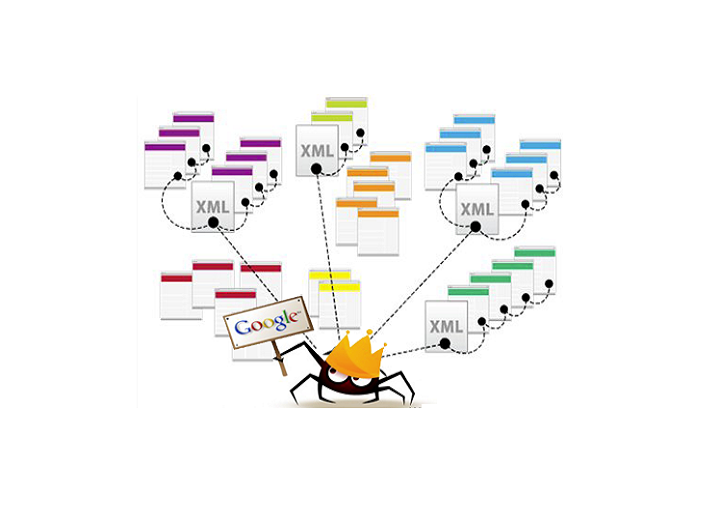

Crawler Googlebot là công cụ chính trong hệ thống Google Search, có nhiệm vụ quét qua các website để thu thập dữ liệu. Quy trình crawl thường bắt đầu từ danh sách URL đã biết (sitemap, liên kết nội bộ, backlink). Sau đó, Googlebot tải về mã nguồn HTML, CSS, JavaScript và các tệp liên quan.

Đây là phần thường được trích dẫn làm Featured Snippet cho câu hỏi “Googlebot thu thập dữ liệu website như thế nào”.

Tốc độ crawl của hệ thống Google Search không phải lúc nào cũng giống nhau, mà bị chi phối bởi nhiều yếu tố:

Một số hiểu sai phổ biến về quá trình crawl của Google Search Engine:

Sau khi crawl xong, dữ liệu được gửi đến indexer. Tại đây, hệ thống Google Search sẽ:

Đây là quy trình cơ bản thường được Google mô tả để giải thích cách hệ thống Google Search lập chỉ mục.

Indexer là thành phần then chốt của Google Search Engine, quyết định nội dung nào sẽ được hiển thị. Vai trò chính của indexer gồm:

Không có indexer, dữ liệu mà crawler thu thập sẽ trở nên vô nghĩa, vì không thể đưa vào cơ sở dữ liệu phục vụ tìm kiếm.

Một số hiểu lầm phổ biến khi nói về cách Google Search index trang web:

Thuật toán Google Search sử dụng hàng trăm tín hiệu để xác định nội dung nào phù hợp nhất với nhu cầu tìm kiếm của người dùng. Các yếu tố thường được nhắc đến gồm: độ liên quan, tính mới mẻ, chất lượng tổng thể và trải nghiệm người dùng.

Đây là phần có thể được trích dẫn làm Featured Snippet cho câu hỏi “Thuật toán Google Search đánh giá nội dung như thế nào”.

Một trong những yếu tố quan trọng để cải thiện vị trí trong hệ thống Google Search là E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness).

Nếu website thiếu các tín hiệu E-E-A-T, rất khó đạt vị trí cao ngay cả khi tối ưu từ khóa tốt.

Một quan niệm sai lầm phổ biến là thứ hạng trong Google Search Engine chỉ phụ thuộc vào số lượng backlink. Thực tế, backlink chỉ là một trong nhiều ranking factors.

Hệ thống Google Search hiển thị kết quả trên SERP (Search Engine Results Page) theo nhiều định dạng:

Để một trang có thể xuất hiện trong snippet hoặc PAA, cần đáp ứng các điều kiện sau:

Nhiều người nghĩ rằng Google Search hiển thị kết quả giống nhau cho mọi người. Thực tế, kết quả có thể khác nhau do:

Điều này chứng minh hệ thống Google Search không chỉ cung cấp một bộ kết quả cố định mà liên tục điều chỉnh để phù hợp với từng người dùng.

Trong kỷ nguyên 2024–2025, nhiều người cho rằng chỉ cần AI tạo nội dung là đủ để thăng hạng trong hệ thống Google Search. Thực tế, AI chỉ đóng vai trò hỗ trợ, còn yếu tố con người mới tạo nên sự khác biệt.

Điều này phù hợp để hiển thị ở dạng Featured Snippet cho câu hỏi “Có nên dùng AI hoàn toàn cho nội dung SEO không”.

Google Search Console là công cụ miễn phí giúp quản trị viên hiểu cách Google Search Engine nhìn thấy website. Việc bỏ qua công cụ này thường dẫn đến sai lầm: không biết trang nào bị loại khỏi chỉ mục, không phát hiện lỗi crawl, hoặc bỏ lỡ cơ hội cải thiện từ khóa.

Một checklist cơ bản khi sử dụng Search Console:

Một sai lầm phổ biến là tập trung vào kỹ thuật “chớp nhoáng” để nhanh chóng lên top, thay vì phát triển nội dung lâu dài. Hệ thống Google Search ngày càng thông minh, nên chỉ những website có chiến lược bền vững mới duy trì được vị trí cao.

Chiến lược này giúp website không chỉ “lên top” tạm thời mà còn duy trì ổn định trên SERP trong nhiều năm.

Việc nắm chắc cách Google crawl, lập chỉ mục, xếp hạng và phân phối kết quả giúp bạn tránh các lối mòn cũ như nhồi nhét từ khóa hay lạm dụng backlink. SEO bền vững đòi hỏi sự kết hợp giữa nội dung chất lượng, tín hiệu E-E-A-T và chiến lược dài hạn phù hợp với định hướng của Google Search Engine.

Không. Hệ thống Google Search ưu tiên crawl dựa trên chất lượng và độ tin cậy của website, chứ không phải vì trang mới hay cũ. Website mới vẫn cần tối ưu kỹ thuật và nội dung để được crawl nhanh hơn.

Crawl budget là số lượng URL mà Googlebot có thể và muốn crawl trong một khoảng thời gian nhất định. Với các website lớn, tối ưu crawl budget giúp Google ưu tiên những trang giá trị và tránh lãng phí tài nguyên.

Không. Hệ thống Google Search ưu tiên index nội dung văn bản, hình ảnh, video và một số định dạng phổ biến. Các tệp phức tạp hoặc không thân thiện với Googlebot có thể bị bỏ qua.

Google cá nhân hóa kết quả dựa trên vị trí của người dùng. Điều này giúp Google Search Engine cung cấp thông tin phù hợp hơn, ví dụ như hiển thị cửa hàng gần nhất hoặc tin tức theo khu vực.

Có. Khi nhiều trang có nội dung giống nhau, Google Search sẽ chọn một bản để hiển thị, còn những bản sao chép thường ít được ưu tiên, dẫn đến giảm cơ hội xếp hạng.